英特尔透露了其基于Nervana NNP架构的一对AI加速器的详细信息。一种是从头开始设计的,用于在“给定的功率预算”内进行深度学习培训,而另一种则是为了在数据中心部署中进行深度学习推理。

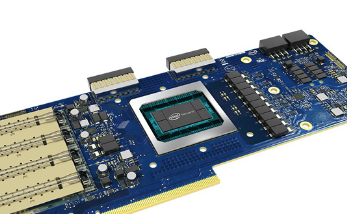

在英特尔Nervana神经网络处理器用于训练(英特尔Nervana NNP-T)AI加速器,代号为弹簧波峰,设有24个量处理核和四个HBM2存储器裸片堆叠,加起来32GB。中央芯片具有688mm的方形管芯,基于TSMC 16nm CLN16FF +工艺。

TPC和HBM2堆栈以及其他组件(例如管理CPU,HBM内存控制器,PCIe Gen 4.0控制器)位于1200mm方形无源插入器上。中央芯片的额定工作频率高达1.1GHz,功耗在150W至250W之间。

在英特尔Nervana NNP-T是指处理当前和开发深层次的学习培训工作负载。据英特尔称,该AI加速器旨在尽可能多地重用裸片上的数据,这解释了24个TPC的内存子系统。这将减少从HBM2存储管芯堆栈中获取数据的昂贵过程。该加速器是风冷的,采用OCP加速器模块(OAM)和PCIe尺寸。

代号为Spring Hill 的Intel Nervana神经网络推理处理器(Intel Nervana NNP-I)用于深度学习推理。它以完全不同的外形提供,即用于M.2接口并具有10至50W的功率范围。它具有一对10纳米Intel Ice Lake CPU内核。

CPU内核与12个推理计算引擎(ICE)配合使用,以处理AI推理工作负载。推理加速器具有24MB的共享高速缓存,并且具有用于访问LPDDR4内存系统的内存控制器。它同时支持PCIe Gen 4.0和3.0连接。

英特尔Nervana NNP-I似乎还有另一种形式的PCIe扩展卡。有关更多信息,请访问各自的产品介绍,即Intel Nervana NNP-T和Intel Nervana NNP-I。对于它的两个AI加速器官方宣布英特尔可以完整地阅读这里。

2016年,英特尔收购了AI初创公司Nervana以增强其AI产品组合,而Intel Nervana NNP于2017年10月首次宣布。英特尔希望与其新的至强可扩展处理器一起挑战基于NVIDIA GPU的AI立足点。